Woensdag 12 oktober was het Digital Analytics congres in het Media Plaza Utrecht georganiseerd door de MOA (Center for Information Based Decision Making & Marketing Research). Het was een dag vol interessante nationale en internationale sprekers en een aantal mooie business cases van Nederlandse spelers. Het meest besproken onderwerp van de dag was kwaliteit van data, in dit blog zal ik twee sprekers uitlichten die hierover spraken en een spreker die het had over extra aanknopingspunten bij je analyses.

Brian Clifton

Brian Clifton was de eerste spreker en begon bij het begin van analytics in 2005, hoe klein het toen was met ongeveer 30.000 actieve gebruikers. In dat zelfde jaar lanceerde Google Analytics en een week na lancering had het al 100.000 aanvragen. Daarna heeft het platform een jaar lang stil gestaan omdat het de aanvragen niet aan kon. Nu meer dan tien jaar later zijn er heel veel pakketten bijgekomen én verloren gegaan maar Google Analytics domineert nog steeds de markt. Er zijn heel veel nieuwe mogelijkheden bijgekomen en een analytics pakket is gemakkelijk met klein stukje code geïnstalleerd. Maar welke analist is er betrokken bij de implementatie van een analytics pakket en wie vertrouwt alle data?

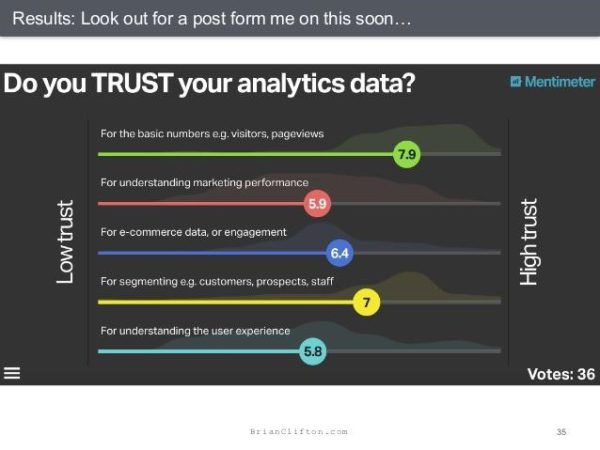

De meeste bezoekers van het congres vertrouwden de basisstatistieken uit hun analytics pakket maar naarmate de onderdelen ingewikkelder werden ging dit vertrouwen omlaag. Maar de onderdelen waar het vertrouwen het laagst ligt zijn juist het interessantst. Hier haal je de meest waardevolle inzicht uit en kun je inkomsten- en uitgaven-stromen optimaliseren.

Vroeger was hier totaal geen inzicht in en Brian Clifton kwam met een mooie quote van John Wanamaker:

“Half the money I spend on advertising is wasted; the trouble is I don’t know which half.”

Tegenwoordig kan je hier wel inzicht in krijgen mits je analytics pakket goed geïmplementeerd is. Maar dit blijkt vaak niet het geval te zijn. Brian Clifton krijgt dit niet alleen van de bezoekers van congressen zoals deze te horen maar ziet dit ook terug bij zijn klanten. In alle jaren bij Search Integration is het maar twee keer voorgekomen dat de data kwaliteit van een van zijn klanten volgens zijn standaard acceptabel was. Omdat de data vaak geaggregeerd is, is vervuilde data bij een slechte implementatie niet te schoon te krijgen. En de schade kan catastrofaal zijn: een aantal maanden geleden vertelde een collega over een partij waarbij 1 jaar aan A/B testresultaten weggegooid kon worden omdat de implementatie en data niet deugden. Maar wie is verantwoordelijk voor het waarborgen van de data kwaliteit en checkt regelmatig of deze nog klopt?

Na alle bangmakerij sloot Brian Clifton af met 5 punten om data kwaliteit te verbeteren.

- Neem verantwoordelijkheid voor de data kwaliteit.

- Voorkom het trainen van je CxO’s en presenteer oplossingen.

- Meester campagne tracking (om inzicht krijgt in je marketing campagnes).

- Beperk de toegang tot en rechten in een analytics pakket.

- Controleer en verifieer regelmatig.

Brian Clifton heeft een boek geschreven over hoe je Google Analytics succesvol kan implementeren en hij was zo vrijgevig om deze aan alle deelnemers van het congres te geven. Aan een van reageerders zullen we het boek van Brian Cliftion ‘Succesful Analytics’ weggeven.

Ik denk dat er inderdaad te weinig aandacht en aan data kwaliteit word besteed, ik heb hier zelf ook altijd zo min mogelijk tijd aan willen besteden. Maar Brian Cliftion ziet waarschijnlijk ook maar één kant van het verhaal, bedrijven bij wie alles goed geregeld is zullen hem niet om hulp vragen. Maar wat vind jij, vertrouw je alle data in je analytics pakket? Controleer je dit regelmatig?

Measuring Engagement door Simo Ahava

Simo Ahava ging door op het thema van data kwaliteit en begon zijn sessie met het benoemen van alle mankementen van Google Analytics. Wist je bijvoorbeeld dat een sessie verloopt als een acquisitie campagne verandert, na 30 minuten van inactiviteit of om 12:00 ‘s nachts? We hebben weinig inzicht in de achterkant van Google Analytics en het is in dat opzicht een blackbox. Als gebruiker weet je niet precies hoe alles gemeten wordt dus hoe kan je met zekerheid inzichten presenteren met al deze mankementen in je achterhoofd?

Maar gelukkig bestaat Google Tag Mananger, Simo Ahava’s favoriete tool en volgens hem de enige manier om Google Analytics tracking te implementeren. Naast de implementatie van Google analytics kun je, waar het platform tekort komt, je informatiebehoefte vervullen door custom metrics te creëren. Eén van de custom metrics die Simo Ahava gebruikt is active time on page. Waar bezoekers volgens Google Analytics gemiddeld 7 minuten op een bepaalde pagina waren was volgens zijn eigen custom metric ‘Active time on page’ die tijd maar 1 minuut. Ook gebruikte hij de custom metric ‘Time until bounce’ hieruit bleek dat alle gebouncde bezoekers vanuit een zoekmachine toch gemiddeld 5 minuten op zijn website blijven voordat ze de pagina verlaten.

De vijf take aways van zijn presentatie waren:

- Data kwaliteit moet verdiend worden en krijg je niet zomaar.

- Google Analytics is te algemeen out-of-the-box.

- Een analytics platform moet ge-customized worden naar je informatiebehoefte zodat je geïnformeerde acties kunt ondernemen.

- Inzicht in meetmogelijkheden is een geweldige proxy voor alle meetbare doelen.

- Kennis over web technologieën is een must voor de webanalist van tegenwoordig.

Ik wil zeker de custom metric active time on page gaan gebruiken. Ik browse zelf ook met meerdere tabs open en dan zal de Google Analytics time on page nooit kloppen. Hoe je deze en andere custom metrics kan toevoegen aan jouw analytics account staat uitgelegd in de presentatie slides van Simo Ahava en op zijn blog.

Steen Ramussen

Gelukkig ging het congres niet alleen maar over de kwaliteit van de data en de juiste implementatie van een analytics pakket. Steen Rasmussen sprak in zijn presentatie ‘It’s not about the data’ over de het toevoegen van context aan je analyse.

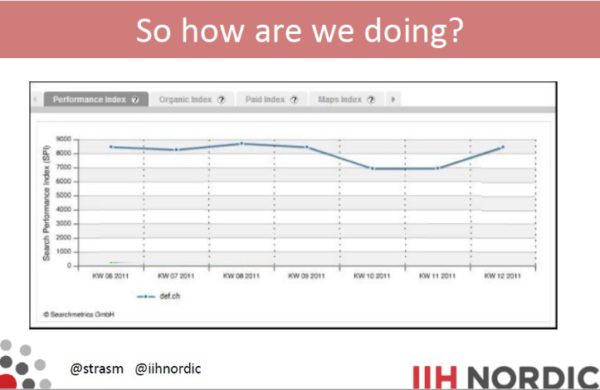

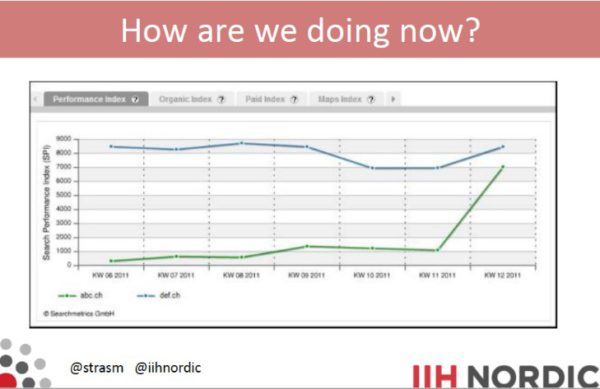

Als analist ben je vaak op zoek naar dat ene gouden segment maar volgens Steen Rasmussen is dit een mier op de kont van een olifant, iets wat heel klein is. We hebben verschillende databronnen tot onze beschikking en duiken daar diep in tijdens de zoektocht naar dat gouden segment. Maar staat de olifant op de Noordpool, in een drukke straat in Tokyo of ergens op de Savanne? In other words, we vergeten de context in onze analyses. Als voorbeeld liet Steen Rasmussen afbeelding 1 zien, hier zie je de search performance index van een bedrijf en deze is na een kleine dip weer gaan stijgen dus alles lijkt oké, toch? Totdat we de prestaties van de concurrent ernaast leggen. Deze is explosief gegroeid en er moet actie worden ondernomen als het bedrijf een sterkere positie t.o.v. de concurrent wilt onderhouden.

Maar welke bronnen kun je gebruiken om context aan je analyses toe te voegen?

Dit kan je binnen je bedrijf vinden door ook te kijken naar:

- Bedrijfsdoelstellingen

- Sales data

- Financiële data

- Business intelligence

- HR Data

- Productie data

- Customer support

Ook is er buiten je bedrijf veel te vinden over de markt en zijn er websites als Google Trends, Search Metrics en Similar Web waar je veel informatie uit kunt halen.

Steen Rasmussen vergeleek context in een analyse met een cockpit. Je kan de instrumenten lezen en rapporteren maar als je niet weet waar je heen vliegt, kan er geen actie ondernomen worden. Bij het rapporteren of presenteren van je analyse is dit precies hetzelfde. Context kan heel veel waarde aan je inzichten en geadviseerde acties toevoegen. Hij eindigde met dat dit de kracht is van een goede analist is, inzichten en acties o.b.v. je analyses communiceren.

Voor analyses van pijnpunten van een website probeer ik altijd met customer support te spreken over de klachten die zij over de website krijgen. Waar kijken jullie allemaal naar naast analytics data?

Wil je context bij dit verhaal? Deze kan je vinden in de presentatie slides van Steen Rasmussen.