We zien ze allemaal voorbij komen, op het werk, op LinkedIn, op congressen: voorbeelden van A/B testen met 10%, 20% en 25% uplift. Leuk om te zien waar andere bedrijven mee bezig zijn en goede inspiratie om je eigen optimalisatie-programma mee te verrijken. Maar er is een aantal data valkuilen waar je goed op moet letten bij deze voorbeelden, en met name één ding is zeer belangrijk: stel de juiste vragen.

1. Wat is de belangrijkste metric?

Een van de belangrijkste vragen die ik altijd stel bij dit soort voorbeelden: “Welke metric is er gebruikt om dit resultaat op af te rekenenen?” Het liefst reken je een A/B test af op een doel waar ook daadwerkelijk extra omzet mee gegenereerd wordt. Maar uiteraard is dit afhankelijk van de bandbreedte van je website. Als je niet genoeg verkeer op je pagina’s hebt om op orders af te rekenen wordt vaak gekozen om de doorklik als metric te nemen. Prima, maar vertel dit er altijd bij, want een uplift van 15% in doorkliks is heel anders dan dezelfde uplift in orders en omzet. Ook als je doorkliks als metric neemt is het belangrijk dat je de eindconversie in de gaten houdt. Het aantal doorkliks is namelijk makkelijk te beïnvloeden, maar als de orders door je verandering kelderen dan wil je misschien nog even nadenken of je de verandering daadwerkelijk wilt implementeren.

2. Zijn de aantallen groot genoeg?

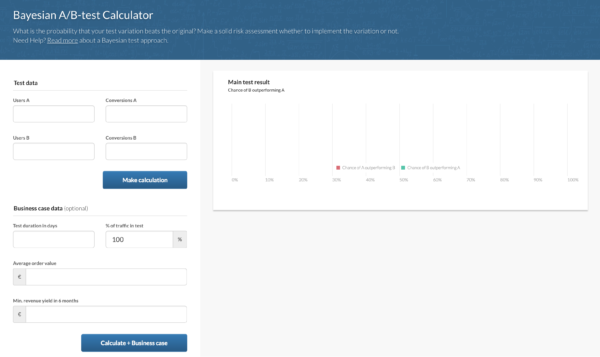

We zien nog te vaak dat geëxperimenteerd wordt op pagina’s waar eigenlijk veel te weinig verkeer is om betrouwbare A/B testen op uit te voeren. Vraag daarom, waar mogelijk, altijd naar de absolute cijfers. Een verhoging van 25 naar 30 orders is natuurlijk heel wat anders dan een verhoging van 600 naar 720 orders. Toch is het beide een uplift van 20%. Om dezelfde reden is het belangrijk om vooraf te kijken hoeveel bezoekers en conversies je nodig hebt om überhaupt te kunnen testen op een bepaalde pagina en of het effect dat je ziet ook daadwerkelijk statistisch significant is en geen toeval. Gebruik hiervoor een A/B test significantie calculator als bijvoorbeeld www.abtestguide.com.

3. Wat is de kwaliteit van de technische implementatie?

Of je nu al een tijdje bezig bent met A/B testen of net begint, het is altijd belangrijk om de implementatie van je A/B test tool goed te controleren. Dit kun je doen aan de hand van een aantal vaste checks. Vertrouw niet blind op de aantallen die je A/B test tool laat zien. Door een event naar je web analytics tool te sturen voor zowel de A als de B variant is het mogelijk om de analyse in je web analytics tool te doen. Omdat je de rest van je web analyses ook in deze tool doet, is het fijn om van één waarheid uit te kunnen gaan. Ook maakt je webanalytics tool het makkelijker om bij de analyse naar verschillende segmenten te kijken.

Zorg vervolgens dat alle bezoekers op de pagina waar het experiment plaatsvindt eerlijk verdeeld worden over A en B. In het totaal moet 100% van het verkeer op die pagina in de A/B test zitten en de verdeling per variant moet dicht in de buurt van 50/50 zijn. Om te controleren of de verdeling ook echt 50/50 is, kun je de Sample Ratio Mismatch calculator van Ronny Kohavi (Microsoft) gebruiken.

4. Wat heeft je experiment in euro’s opgeleverd?

Tot slot is het belangrijk je af te vragen wat de test in euro’s heeft opgeleverd maar vooral ook wat deze heeft gekost. Stel, de uplift levert je in 6 maanden 20.000 euro op, maar de development en bijkomende kosten zijn 17.500 euro, is het dan wel de moeite waard om deze test te laten bouwen?

Dit zijn in ieder geval de 4 valkuilen die ik het meest tegenkom in mijn werk, maar er zijn vast nog veel meer vragen die je kunt stellen om de werkelijke waarde van je experimenten te bepalen. Deel daarom vooral je eigen bevindingen in de comments!