Ronny Kohavi, general manager van het analyse en experimentatie team van Microsoft, begon in 2001 al met het uitvoeren van online experimenten. Na een aantal jaar bij Amazon gewerkt te hebben is hij nu verantwoordelijk voor het gehele experimentatie platform van Microsoft en daarmee voor gemiddeld 1200 experimenteren per maand. Tom van den Berg (Online Dialogue) interviewt Ronny Kohavi, general manager bij Microsoft, tijdens Conversion Hotel 2017 over experimenteren op grote schaal.

Hoe kwam je in 2001 al op het idee om te gaan A/B-testen?

Het uitvoeren van gecontroleerde experimenten was in 2001 al bekend. Ik heb de techniek zelf als eerste toegepast in e-mailcampagnes om de waarde van e-mails te beoordelen. Later toen ik bij Amazon startte was er al een intern project genaamd Weblab waar regelmatig nieuwe ideeën werden getest aan de hand van online experimenten. Bij Microsoft was deze methode echter nog niet heel bekend, dus toen heb ik daar het idee geopperd om te starten met experimenteren.

Is er veel verschil in de A/B test methode nu en 15 jaar geleden?

De statistiek is door de jaren heen hetzelfde gebleven. Ronald Fisher kwam rond de jaren 20 met de basistechnieken die we nog steeds toepassen. Het verschil is de online wereld, die zo zijn eigen uitdagingen heeft. We hebben veel geleerd en gepubliceerd, maar hoewel de basisstatistieken erg op elkaar lijken, vereist de uitvoering in de praktijk veel meer inspanning dan men zou denken.

Kun je ons iets vertellen over je huidige functie bij Microsoft?

Ik ben de algemene manager van een team dat ‘analysis & experimentation’ wordt genoemd. Daar bouwen we hét centrale platform voor Microsoft om gecontroleerde experimenten uit te voeren op al onze producten. De belangrijkste hiervan is natuurlijk Bing, maar we voeren ook gecontroleerde experimenten uit op MSN, Office, Xbox, Skype en Outlook. En dat zorgt ervoor dat heel veel mensen experimenteren via ons platform.

En hoe ziet dat er per dag uit? Zou je dat kunnen omschrijven?

We geven een maandelijkse opleiding en we hebben een lab waar we je leren ons platform te gebruiken. Daarnaast organiseren we sessies waar je een A/B test met ons deelt en dan gaan we je helpen bij het analyseren en doorgronden van de resultaten. Maar we proberen mensen het meeste zelf te laten doen. Daarom geven we iedereen de tools waarmee ze zelf kunnen analyseren maar tegelijkertijd ook de betrouwbaarheid van de resultaten kunnen waarborgen.

Wat is de winnaar-ratio bij Microsoft?

Bij Microsoft zijn er verschillende teams die zelfstandig experimenteren. Dus er zijn teams die relatief nieuw zijn met experimenteren en daar heeft ongeveer ⅓ van de experimenten een positief significant resultaat (je aanpassing heeft gezorgd voor verbetering), ⅓ heeft geen effect en ⅓ heeft een significant negatief effect (je aanpassing verslechtert de resultaten).

Maar voor de meer geoptimaliseerde domeinen, zoals Bing, die al heel lang experimenten uitvoeren, is het succes moeilijker te vinden. Hier is de winnerratio ongeveer 10% tot 20% van alle testideeën. Al is dat nog steeds veel wanneer je zoveel experimenten uitvoert. Kleine verbeteringen tellen op tot iets groots, dus je moet heel veel kleine experimenten doen wil je belangrijke veranderingen teweeg brengen in het bedrijfsperspectief.

Kun je ons iets vertellen over hoeveel uren je besteedt aan een test?

De doorlooptijd van een experiment is minimaal een week. Maar als je kijkt naar de analyse dan varieert het aantal uur tussen eenvoudige en meer gecompliceerde A/B testen flink. De meeste analyses zijn bij ons geautomatiseerd, maar als er afwijkingen zijn dan besteden we meer tijd aan het onderzoeken wat precies die afwijking veroorzaakt heeft. Bij een gecompliceerde test kan zo zelfs meerdere dagen duren voordat men door heeft wat de resultaten betekenen. Daarnaast voeren we een experiment soms meerdere keren uit met kleinere variaties om te begrijpen wat precies de gedragsverandering veroorzaakt.

Waarom hebben jullie ervoor gekozen om een eigen experimentatie platform te bouwen en niet voor een testtool als Optimizely?

Daar is een aantal redenen voor:

- We zijn begonnen met het bouwen van het platform nog voordat er sprake was van Optimizely.

- Een andere reden is dat zelfs in de huidige tools op de markt de complexiteit die we nodig hebben, niet aanwezig is om onze bedrijfsstatistieken optimaal te definiëren.

- En een derde reden is dat we veel verschillende databronnen aan elkaar koppelen en dat is heel moeilijk in een product zoals Optimizely.

Al maken we op verschillende plaatsen bij Microsoft wel gebruik van third-party tools zoals Optimizely, voor de meer eenvoudige experimenten die niet afhankelijk zijn van gecompliceerde statistieken en niet gericht zijn op verbetering op de lange termijn.

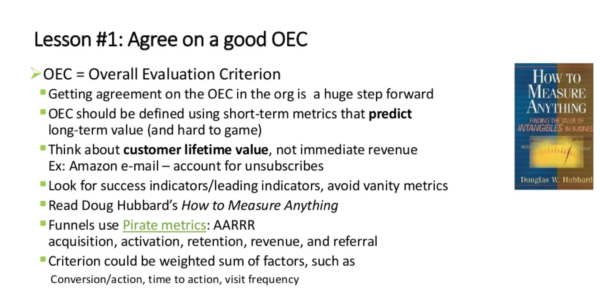

In je presentaties en tijdens workshops heb je het veel over de OEC. Kun je daar wat meer over vertellen?

Ieder bedrijf dat experimenteert, moet weten waar ze naartoe werken. En de Overall Evaluation Criteria is idealiter een statistiek of soms een combinatie van belangrijke statistieken die je vertellen of een idee positief is voor de organisatie. Het moeilijkste onderdeel hiervan is het vertalen van korte termijn metingen (een experiment dat een week of twee duurt), naar iets dat voorspellend is voor succes op de lange termijn.

En uit ervaring weet ik dat de testideeën die mensen bedenken over het algemeen gericht zijn op de korte termijn. Ik kan bijvoorbeeld heel simpel de opbrengst enorm verhogen door meer advertenties weer te geven. Maar als ik dat doe, dan zal er over een paar maanden geen product meer op de markt zijn. Uit onze experimenten blijkt namelijk dat als we te veel advertenties toevoegen mensen eerder kiezen voor concurrerende producten.

Een ander belangrijk element dat je citeerde was ‘Sample Ratio Mismatch’ (SRM). Kun je ook daar iets meer over vertellen?

Je wilt de verdeling tussen de bezoekers die in variant A of in variant B zitten altijd zo gelijk mogelijk hebben. In een statistische context zegt de wet van de grote aantallen dat het steekproefgemiddelde van een aselecte steekproef uit een populatie, met hoge waarschijnlijkheid weinig verschilt van het populatiegemiddelde. Dus als je een experiment uitvoert op 50/50, dan moet de verdeling ook daadwerkelijk 50/50 zijn. Maar waar mensen vaak geen rekening mee houden is dat als je te maken hebt met grote bezoekers aantallen, een verschil als 50,2% al heel onwaarschijnlijk is. Grote kans dus dat er iets mis is als je deze aantallen krijgt. Door deze Sample Ratio Mismatch te berekenen kun je snel fouten ontdekken die je anders misschien verkeerd geïnterpreteerd had.

Denk je dat er een correlatie is tussen het aantal experimenten op jullie platform dat het afgelopen jaar gestegen is en het toenemende succes van Bing?

Nee, ik denk het niet. Ik geloof dat de groei van Bing deels te danken is aan de juiste beslissingen om te investeren in de infrastructuur en ons volledig te concentreren op de OEC. Een van de dingen die je je realiseert als je op zo’n grote schaal experimenteert is dat je door het uitvoeren van experimenten niet alleen de goede functies identificeert, maar juist de slechte eruit filtert. En dat is belangrijk. Als je niet experimenteert dan zijn er altijd een paar goede en een paar slechte ideeën. De waarde van experimenteren is dat je die twee kunt onderscheiden en alleen de goede doorvoert.

Wat is volgens jou de toekomst van experimenteren?

Elk bedrijf dat geavanceerde technieken gebruikt zoals machine learning en het bouwen van classifiers, zal moeten experimenteren. Vroeger kon je zeggen, hier is een aanpassing, die gaan we testen. Maar tegenwoordig is het onmogelijk om dat te doen omdat je met zeer uitgebreide zelflerende modellen werkt. Geen enkel mens kan echt testen of een dergelijk model correct is. Misschien kun je een aantal elementen apart testen, maar de echte test vindt pas plaats met de echte gebruikers. En daarom, hoe meer je overgaat op modellen voor machine learning, hoe meer je zult moeten A/B testen om erachter te komen welke effecten je veroorzaakt.

Dus de markt zal blijven groeien?

Ik geloof absoluut dat het alleen maar meer zal worden.