Je bent lekker bezig met A/B-testen maar je wilt (omdat je tegen je limiet aanloopt) meer experimenteren. De oplossing kan hem zitten in het testen op meerdere pagina’s tegelijkertijd. Maar helpt dit in het versnellen van je CRO programma? Of ben je alleen maar je data aan het vervuilen? Helaas is het antwoord op beide “ja”. De vraag is alleen of de voordelen opwegen tegen de nadelen.

Stel je het volgende scenario voor: een gebruiker komt binnen op een productpagina waar hij in de controlegroep van experiment 1 zit. Hij klikt door naar de winkelmand en ziet daar variant B van experiment 2. Vervolgens vult hij zijn gegevens in en ziet hij variant B van experiment 3 en uiteindelijk converteert hij.

In een dergelijk geval is het moeilijk om te bepalen welke combinatie van varianten voor een winnaar gezorgd hebben.

Het voordeel van meerdere A/B-testen in een user-journey

Ten eerste kun je wanneer je meerdere A/B-testen uitvoert in dezelfde periode uiteraard veel meer experimenten live zetten dan wanneer je dit niet doet. Stel je hebt vier pagina’s in je funnel waar je kan experimenteren en op alle vier de pagina’s moet een experiment vier weken live staan. Als je meerdere experimenten tegelijkertijd live zet, kunnen er vier experimenten per maand tegelijkertijd live staan. Dit zijn 48 experimenten op jaarbasis. Als je steeds wacht totdat het ene experiment klaar is voordat je een nieuw experiment live zet, en je dus maar één pagina tegelijkertijd test, dan zijn dit 12 testen per jaar.

Het simultaan testen van verschillende pagina’s levert in dit geval een versnelling van je CRO programma op. Hierdoor heb je vier keer vaker de kans om iets te leren en verklein je de kans dat je geld laat liggen.

Het nadeel van meerdere A/B-testen in een user-journey

Het meest gehoorde nadeel is de vervuiling van je data. Dit heeft met interactie effecten te maken. Bij een interactie effect ga je ervan uit dat het effect van de ene test invloed heeft op het effect van de andere test. Er zijn hierbij twee scenario’s mogelijk.

Scenario 1

Er zijn in werkelijkheid geen interactie effecten, dus de A/B-testen hebben geen invloed op elkaar. We kunnen er dan van uitgaan dat het prima is om meerdere testen tegelijkertijd live te hebben staan, zonder dat ze je data vervuilen. Daarnaast is je concurrentie waarschijnlijk ook aan het experimenteren en hebben deze experimenten net zo’n grote invloed op jouw experiment als je eigen experimenten. Het kan dus voorkomen dat een gebruiker verschillende websites aan het vergelijken is en in meerdere tabbladen ook een experiment van de concurrent ziet.

Scenario 2

Er is wel een interactie effect. Dit effect kan leiden tot:

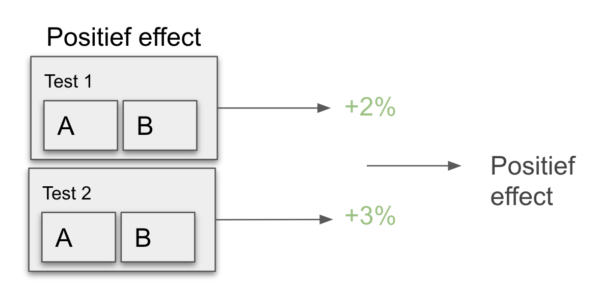

- Er is een interactie effect en de verschillende testen hebben een positief effect op elkaar. Dit wil zeggen dat het effect van variant B van experiment 1 het effect van variant B van experiment 2 versterkt. Hierdoor worden beide testen een winnaar, en dus implementeer je beide testen. Dit effect is echter alleen maar positief wanneer je beide varianten live hebt staan. Doe je dit niet en implementeer je maar een variant, dan kan het zo zijn dat de variant een heel ander effect teweegbrengt.

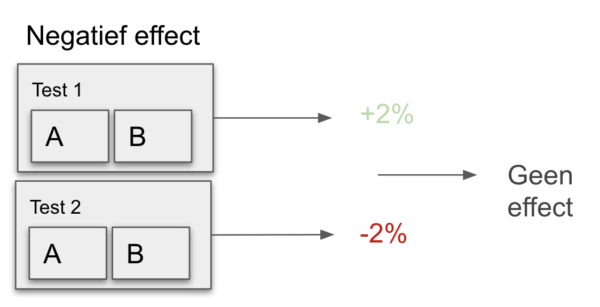

- Er is een interactie effect en de verschillende testen hebben een negatief effect op elkaar. Dit wil zeggen, variant B van experiment 1 verzwakt een mogelijk positief effect van variant B van experiment 2. Hierdoor lijken beide A/B-testen geen winnende varianten op te leveren. Met als gevolg dat je winner ratio daalt, terwijl er mogelijk wel positieve effecten zijn.

Maak de afweging

Helaas weten we van te voren niet of er interactie effecten bestaan waardoor er geen eenduidig antwoord te geven is op de vraag of meerdere A/B-testen tegelijkertijd een probleem vormen. Maar des te belangrijker is het om een goede afweging te maken. Als je grote overlap verwacht (bijvoorbeeld door in beide A/B-testen in te spelen op dezelfde behoefte van de bezoeker) of je experiment erg belangrijk is, test dan afzonderlijk. Is dit niet het geval, ga dan voor snelheid en test tegelijkertijd.

De afweging die je maakt is telkens weer anders, maar daarom juist belangrijk om goed over na te denken. Ik ben erg benieuwd naar jullie ervaringen. Wat is jullie overweging om wel of niet tegelijkertijd te experimenteren binnen dezelfde user-journey?