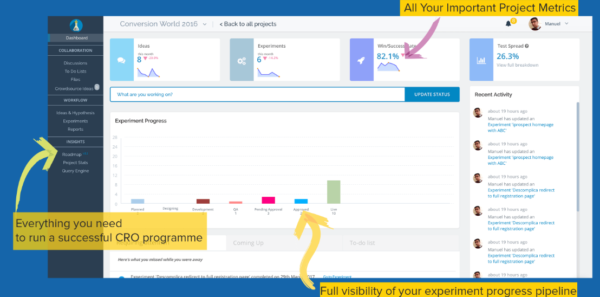

Tijdens Conversion Hotel interviewde Guido Jansen van Euroflorist Manuel Da Costa over zijn tool genaamd Effective Experiments. Effective Experiments is een uitgebreid project management & workflow platform. Een all-in-one oplossing ontworpen om jouw tijdsindeling en de communicatie met stakeholders te verbeteren.

De sessie van Manuel Da Costa op Conversion Hotel ging over de processen, prioriteiten en de uitdagingen die mensen tegenkomen onderweg naar een ‘high velocity testing programma’. Tijdens zijn sessie ging Manuel in discussie met het publiek om erachter te komen hoe deze uitdagingen eruit zien. Waar loopt het publiek tegenaan? Hebben ze bijvoorbeeld moeite met het krijgen van buy-in van stakeholders of cliënten? Lukt het om testen op een redelijk tempo te ontwikkelen en te draaien? Hoe is de samenwerking met andere belangrijke spelers als developers? Of ondervinden mensen juist problemen bij het communiceren van de behaalde resultaten?

Tussen de vele sessies door gaat Guido Jansen in gesprek met Manuel Da Costa om meer te weten te komen over de ontwikkelingen van Effective Experiments en Manuels visie op de groeiende CRO markt.

Ten eerste vroeg ik me af of je veel overeenkomsten en verschillen ziet als je deze zelfde sessie in het buitenland doet?

Omdat conversie optimalisatie nog geen volwassen markt is, zien we regelmatig problemen met het verkrijgen van buy-in. Agencies en bedrijven proberen zich te bewijzen als CRO team, maar blijven tegen dezelfde problemen aanlopen. En dat gebeurt niet alleen in Nederland. Vooral in Noord Europa, waar het niveau nog lager ligt, zien we deze ontwikkeling veel terug. Maar zelfs ook in Duitsland en Engeland, waar de markt een stuk volwassener is, ondervinden mensen dezelfde problemen. We zien mensen die veel geld besteden aan ‘SEO’ en ‘Cost per Click’ terwijl CRO wordt gezien als een reserve optie. Dat zijn de grootste overeenkomsten die ik zie tussen landen. En dan heb je nog andere uitdagingen, zoals te weinig traffic waardoor mensen geen testen kunnen draaien.

Ik heb het idee dat een tekort aan traffic voornamelijk een probleem is voor cliënten hier in Europa. In de US is dat een ander verhaal.

Ja klopt. Als een Europese website in een moedertaal geschreven is dan vallen er ineens heel veel bezoekers weg. Bij een Engelstalige site heb je meer kans om buy-in te krijgen van andere landen. Voor een Nederlandstalige site daarentegen is bijna onmogelijk is om klanten te vinden uit bijvoorbeeld Italië. En dan heb je een probleem als iedereen zegt dat je moet A/B testen en je hebt niet genoeg traffic op je site.

Wat zou jij deze mensen voor een advies willen geven?

Nou ja, het eerste waar je aan moet denken als je problemen hebt met low traffic websites is je ROI. Focus eerst op geld. Doe bijvoorbeeld aan user testing. Haal informatie uit heatmaps en clickmaps en probeer erachter te komen waar de site geld verliest. Als je op deze manier veranderingen kunt aanbrengen die meer ROI opleveren dan kun je deze opbrengsten weer investeren in een betere buy-in.

Om je een voorbeeld te geven: bij Effective Experiments werken we met een cliënt met hele lage traffic en niet genoeg budget om de hele site opnieuw te designen. Om toch informatie in te winnen hebben we op kleine schaal een user test gedaan. De resultaten van deze test waren nog al schokkend voor de klant. Want wat bleek was dat de bezoekers op bepaalde punten zo gefrustreerd waren dat ze zelfs begonnen te vloeken. En dan weet je dat je een pijnpunt gevonden hebt.

Voorafgaand aan de user test ging het bedrijf blind te werk. Er was totaal geen interactie met de klant waardoor ze geen idee hadden waar mogelijke verbeter punten zaten. En als je weet waar de problemen zitten en ze duidelijk communiceert aan je stakeholders, dan kun je geld gaan vragen.

Je hebt wel erg betrokken gebruikers hebt als ze beginnen te vloeken op je website.

Precies, je wilt altijd gebruikers die je feedback geven. Op die manier kom je erachter waar verbeteringsmogelijkheden zitten.

Een tweede onderwerp waar ik vandaag ook over wilde praten is de tool Effective Experiments. Hoe lang ben je bezig geweest met het bouwen van de tool?

We hebben de eerste beta versie gelanceerd in maart 2015. En in oktober 2015 zijn we uit de beta versie gestapt. Ik zeg nu dat we uit de beta fase zijn, maar we blijven altijd een ‘beta mindset’ houden. Niets is ooit af. Maar dat was wel het moment dat we onze klanten geld gingen rekenen en de tool verder uit gingen breiden. Maar in totaal nu al twee jaar dus eigenlijk.

En hoe gaat het er nu mee?

Het gaat erg goed. Maar we hebben wel een oneindige backlog. We krijgen veel feedback en we werken erg close samen met onze klanten. Waar ik altijd erg trots op ben is onze snelle development cycle. Response time en klantsucces zijn altijd een focuspunt geweest, met als resultaat dat onze klanten altijd bij Effective Experiments zijn gebleven. De gebruikers zijn altijd blij verrast als ze de tool een tijdje niet meer gebruikt hebben en ze zien dat de tool helemaal aangepast is. Dat zijn dingen waar ik erg trots op ben.

Hoe bepalen of meten jullie klant successen?

Klantsucces betekent voor Effective Experiments eigenlijk gewoon dat we geen klachten krijgen. En met klachten bedoel ik niet dat iets niet werkt, of iets niet op de juiste manier werkt. Eerder opmerkingen waarin men aangeeft dat de tool totaal niet is wat wij ze verkocht hebben. Dat zou ik heel erg vinden. Maar dat is gelukkig nog nooit gebeurd. We meten klant successen vooral aan de hand van de feedback die we krijgen. Lossen wij de problemen op tijd op? En zijn de klanten daarna ook echt tevreden?

Je zei net dat er een oneindig lange backlog is. Aangezien jullie tool zelf een prioretiseringsstap bevat, vroeg ik mij af hoe jullie dit zelf aanpakken? Hoe besluiten jullie welke taken voorrang krijgen?

We hebben een gelijksoortige methode voor prioriteren als Effective Experiments, maar we gebruiken een andere tool hiervoor. Omdat het meer gericht is op productmanagement baseren we alles op features (de functionaliteiten die de tool biedt). Elke feature draagt bij aan een grotere visie. We stellen onszelf de volgende vragen: weerhoudt de afwezigheid van deze feature een klant ervan om iets te doen? Zal de feature ervoor zorgen dat de klant een handeling beter kan uitvoeren? Of is de feature gewoon fijn om te hebben? Als dit het geval is, dan koppelen we terug naar de klant om te vragen hoe de klant zou handelen als de nieuwe feature er niet komt.

Om een recent voorbeeld te geven: we hebben sinds kort de ‘Effective Experiments Customizations’ gereleased: de mogelijkheid om de tool naar jouw wensen aan te passen. We hebben gebruikers die bezig zijn met e-mailmarketing en daarvoor Effective Experiments inzetten. Maar als je kijkt hoe Effective Experiments is opgebouwd en de velden die we vragen om in te vullen: test URL, soort apparaat, de URL’s waar de test op zal draaien, dan sluit dat totaal niet aan bij email marketing. Maar toch vinden mensen een manier om eromheen te werken.

Dat zorgt ervoor dat wij ons gaan afvragen of deze mogelijkheid ook fijn zou kunnen zijn voor onze andere gebruikers. En zo zijn we gekomen tot Effective Experiments Customizations. We luisteren altijd naar onze klanten. Niet alleen naar de feedback, maar we kijken ook wat ze doen om rond een probleem heen te werken. Waarin houdt het probleem de klant tegen in zijn of haar handelen? Waar houdt het probleem het team tegen in wat ze willen bereiken?

Als we het toch over de visie van Effective Experiments hebben, waar zie je de tool naar toe groeien? Welk probleem lost de tool op in de komende 2 of 3 jaar?

De belangrijkste visie van Effective Experiments op dit moment is om mensen zover te krijgen dat ze gestructureerd testen en dat iedereen in de markt het belang van A/B testen inziet. De volgende visie is om mensen echt verder te laten groeien. Als ze de basis van A/B testen kennen en ze hebben het momentum goed, dan is de volgende stap voor Effective Experiments om te voorspellen hoe je meer waarde kunt halen uit je testen. Je gebruikt dus historische data om te voorspellen welke testen je het meest zullen opleveren. Iedere keer als je je testideeën invoert, ontvang je realtime feedback over de plek waar je jouw ideeën eerder getest hebt en wat de succesratio van die testen was. Op deze manier krijg je meer grip op je optimalisaties en kun je sneller werken.

Maar daarnaast werken we met een aantal entreprises die ook weer hun eigen wensen hebben. En ook voor hen hebben we een aparte backlog. En als laatste willen we de mogelijkheid inbouwen dat mensen hun eigen visualisaties kunnen maken en zo hun inzichten kunnen makkelijk kunnen delen met hun team.

Als we het hebben over enterprises, gaan jullie daarvoor een aparte sectie toevoegen aan het prijsmodel?

Dat zou kunnen. Afhankelijk van de eigenschappen en hoe het product opschaalt zal er een vaste set onderdelen zijn die alleen voor enterprise klanten gelden. Maar we zullen voornamelijk altijd blijven luisteren naar bedrijven die kleinschaliger testen. Het is deel van onze missie om mensen te helpen bij de ontwikkeling van ‘hier en daar een A/B test’ naar een gestructureerd testprogramma. Ik denk ook dat er altijd gebruikers blijven die op dit niveau werken. Daarnaast willen we dat klanten door te tijd heen met ons meegroeien.

Laatste vraag, hoe zie je onze markt in 2017 ontwikkelen?

Ook in 2017 is er nog steeds behoefte aan conversion optimizers. Maar er zijn veel nieuwe trends in machine learning en AI (Artificial Intelligence) die een grote rol gaan spelen. Het is nog geen volwassen markt, maar dat zal volgens mij niet lang meer duren.

Wil je meer weten over de tool of een gratis demo aanvragen? Kijk dan op: Effective Experiments.