Lizzie Eardley deelde tijdens de vijfde editie van Conversion Hotel afgelopen november Skyscanner’s inzichten op het gebied van data. Bij Skyscanner staat experimenteren hoog in het vaandel, met dagelijks 500 experimenten die live staan en in totaal al meer dan 10.000 experimenten die afgerond zijn.

Het uitvoeren van betrouwbare experimenten is belangrijk om de juiste resultaten te behalen. Lizzie deelde valkuilen die zij tegenkomt bij Skyscanner, haar zogenaamde “statistical ghosts”.

Ghost 1: Bijna significant

Bij een frequentistische aanpak kun je geen uitspraken doen als: “Deze test is bijna significant”. Je bepaalt van te voren een p-waarde en achteraf beoordeel je de test daarop. Er zijn dan drie mogelijke uitkomsten:

- In de test is een significant positief effect gevonden met een bepaalde zekerheid.

- In de test is geen verschil aangetoond tussen de twee varianten.

- In de test is een significant negatief effect gevonden met een bepaalde zekerheid.

Dus stel: je bepaalt het significantie niveau op 95% (een p-waarde van 0.05) en het resultaat geeft een p-waarde van 0.06, dan kun je niet concluderen dat de test bijna significant is. Lees meer over deze valkuil in het artikel van Kyra Delsing over p-hacking.

Ghost 2: Meerdere segmenten

Wanneer je naar meerdere segmenten kijkt in een A/B-test, wordt de kans dat je een vals positieve uitkomst ziet bij ieder segment een stukje hoger. Dus hoe meer segmenten je bekijkt, hoe hoger de kans dat een van deze segmenten een (vals) positief effect laat zien. Het gaat zelfs zo ver dat bij 13 segmenten de kans 50% is dat een of meer segmenten een vals positief resultaat laten zien.

Helaas kun je niet zien welke dit is geweest en of dit daadwerkelijk het geval was. De oplossing hiervoor is om te corrigeren voor het bekijken van meerdere segmenten. Veel gebruikte correctiemethodes hiervoor zijn de Bonferroni correctie of de Benjamini Hochberg correctie. Daarnaast kun je bij een segment winnaar altijd hertesten.

Ghost 3: Slechte metric, verkeerde test

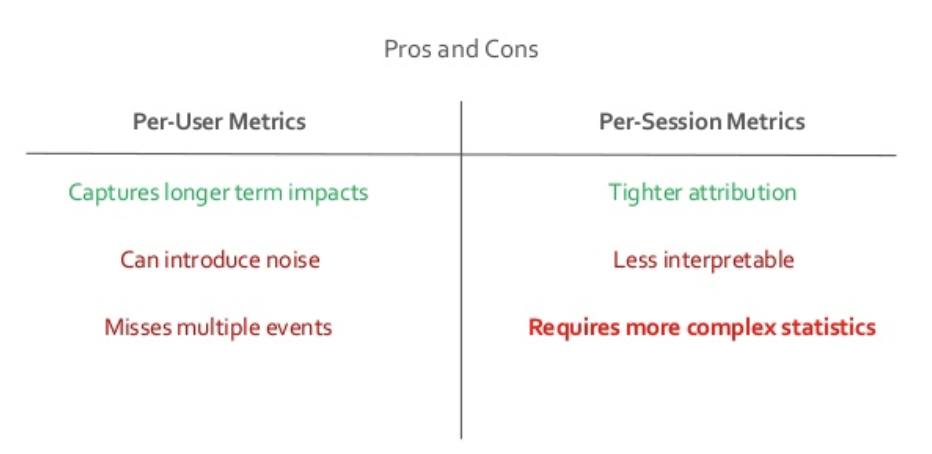

Voorafgaand aan een test bepaal je op welke metric je jouw test gaat afrekenen. Denk bijvoorbeeld na of je op gebruiker of op sessies wilt afrekenen. Vaak heeft gebruiker-niveau de voorkeur, omdat je dan langere termijn effecten meet. Maar sessie-niveau kan ook een goede keuze zijn als je bijvoorbeeld herhaalgedrag wilt stimuleren. Wel wordt de statistiek dan iets complexer. Het kan namelijk zo zijn dat je het aantal sessies per gebruiker verhoogt waardoor de sessies niet meer onafhankelijk zijn (en dit is wel een voorwaarde voor de meeste statistische toetsen).

Ghost 4: Spieken

Er is volgens Lizzie een aantal redenen waarom je wel wilt spieken tijdens een test. Zo wil je onder andere checken of al je data goed binnenkomen en of een experiment geen negatief effect heeft op je overall metrics. Op die manier kun je slecht presterende testen vroegtijdig stoppen en ruimte maken voor de volgende test.

Spieken heeft helaas ook een aantal nadelen. Wanneer je de intentie hebt ook te acteren op wat je ziet, is er een andere statistische methode nodig dan wanneer je geen intentie hebt om bijvoorbeeld een test vroegtijdig te stoppen. Een voorbeeld hiervan is sequential testing of continuous testing.

Kortom, er zijn veel verschillende valkuilen die de betrouwbaarheid van je experimenten kunnen schaden. “Je kunt je nooit beschermen tegen alles, maar zorg er in ieder geval voor dat je mensen goed getraind zijn, dat ze snappen waar ze naar kijken en dat veel gemaakte fouten bij jou niet gemaakt kunnen worden”, aldus Lizzie Eardley.

Wil je meer weten over Conversion Hotel of de presentatie van Lizzie Eardley? Klik dan hier voor meer informatie over de conferentie, de sprekers, de slides en aantekeningen van de presentaties tijdens Conversion Hotel 2018.