In mijn artikel van gisteren introduceerde ik Tableau als een ‘Visual analytics’ tool gespecialiseerd in het snel houden van grote multi-dimensionale databases. Vandaag bespreek ik een aantal praktijkvoorbeelden van hoe je inzichten uit Tableau kunt halen.

Vodafone – Tableau in de praktijk

Geert Jansen – BI demand and capability manager bij Vodafone – vertelt over het beslissingstraject waarin Tableau is gekozen tot hun data-exploratietool. Een van de belangrijkste doelstellingen bij de overweging was self-service: het ontlasten van het BI team. Andere eisen van Vodafone waaraan Tableau moest voldoen (en voldeed):

- Moet kunnen omgaan met grote hoeveelheden data.

- Interactive dashboards.

- CSV export-functionaliteit.

- Mobile first (gebruik op telefoons en tablets).

De case betrof het bepalen van de juiste ‘Next best activity’ in het Vodafone call center: met het juiste aanbod op maat is van een servicegesprek namelijk vaak een verkoopgesprek te maken. Denk hierbij aan een ‘retention offer’ als de contractduur bijna ten einde loopt.

Deze real-life casus maakte gebruik van de volgende data: call center medewerker (‘agent’), aantal gedane en geaccepteerde aanbiedingen, en inhoud aanbieding (‘offer’).

Het getoonde dashboard bevatte de volgende deelrapporten: maand, omzet, ratio geaccepteerde aanbiedingen van totaal(‘acceptance rate’), top offers en top agents.

De hele zaal was er getuige van dat met slechts een aantal klikken de volgende inzichten uit de data konden worden gehaald:

- 4 offers waren samen verantwoordelijk voor 80% van de omzet

- De 2 agents hadden beide een acceptance rate van bijna 100% (wow!)

- Deze 2 succesvolle agents leverden geen ‘maatwerk’, maar waren eenvoudigweg zeer bedreven in het verkopen van slechts 2 offers (oa roaming holiday).

- Dat de acceptance rate zo hoog lag kwam niet door het offer: andere agents haalden met hetzelfde aanbod slechts een acceptance rate van 4%!

Op basis van deze inzichten heeft Vodafone zich gericht op de verkoop van deze 2 potentiële (!) overall best sellers en zich afgevraagd of eens sales training aan de agents door de top verkopers een commercieel interessante overweging zou zijn.

De Business case: training door top 2 verkopers aan de andere agents verhoogd (dikwijls lage) acceptance rate met 25% (relatief, dus van 4 naar 5%). Met deze voorzichtige schatting bleek deze overdracht van sales-kennis commercieel de moeite waard… en was de investering in Tableau meerdere malen terugverdiend!

Big Data, webanalyse en ‘closing the loop’

Tijdens de afsluitende vragenronde vroeg ik of Tableau ook gebruikt kan worden voor ‘Big Data’: het koppelen van meerdere data-bronnen in de software zelf (in plaats van met veel moeite in een cube waarop Tableau dan weer wordt aangesloten).

Dit lijkt eenvoudig te kunnen: een extra databron werd geselecteerd en de ‘matching ID’ voor een ‘join’ werd voor onze ogen gedefinieerd.

(Big) Data is messy data

Menig analist kan beamen dat het bewerken van de data vóór de daadwerkelijke analyse een groot deel van zijn werkzaamheden uitmaakt. Een voorbeeld hiervan is het bundelen van oneigenlijke varianten: de waarden voor appl, apple, ap pel en aple dienen in je rapportage meegeteld te worden onder appel. Ook wil je groeperen, bijvoorbeeld alle inwoners van Amsterdam West indelen in een groep ‘West’. In Tableau is dit een fluitje van een cent.

Voorbeelden webalyse?

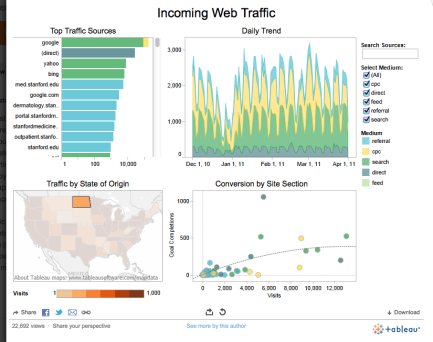

Leuk dat Tabeau zo geschikt is voordata-analyse, maar kun je er ook web analyse mee verrichten? Ja, aldus Stephane Hamel van Cardinal Path, die Tableau aansloot op de Google web analytics API.

Tip: klik op de afbeelding voor een interactief dashboard… na een selectie duurt het even voordat deze webvariant van Tableau zich update.

Ook schijnt Tableau goed samen te werken met het nu nog redelijk onbekende web analytics software pakket SnowPlow, zoals deze video laat zien.

Big Data is samenwerken van verschillende afdelingen en disciplines

De afstand tussen webanalyse en andere vormen van Business intelligence wordt steeds kleiner. In het kader van ‘Big Data’ (bedrijfsbreed en over de gehele duur van de klantrelatie optimaliseren op basis van data) zouden deze vormen van analyse zelfs volledig moeten samengaan .

Voor deze hoognodige versmelting van nu deze nog afzonderlijke analyse-disciplines moeten

- alle databronnen in de gehele organisatie beschikbaar zijn (data moet “ontsiloot” worden)

- ook niet-experts met de data kunnen werken (data-analyse moet gedemocratiseerd worden)

Uit het voorgaande moge duidelijk zijn dat Tableau – of een andere gebruiksvriendelijke visualisatietool – een belangrijke rol kan spelen in het (Big) Data-gedreven maken van organisaties!

Ik ga daarom spoedig mijn gratis demo-versie downloaden en zo snel mogelijk een aantal databronnen aan elkaar knopen en ‘doorklikken’!

Heb jij al gewerkt met Tableau? Reageer op dit artikel en laat weten wat je ervan vindt. Ik ben erg benieuwd naar jullie ervaringen!