AB testen wint meer en meer terrein. Het principe van een test waarbij je tegelijkertijd op een random populatie webpagina variant 1 test tegen webpagina variant 2 is veel logischer dan een test waarbij je variant 1 in periode A met variant 2 in periode B vergelijkt. Dit vanwege het simpele feit dat de omgevingsvariabelen in de AB test stabiel zijn en evenveel invloed hebben op de uitkomst. Bij het uitvoeren en analyseren van AB testen kun je echter zoveel fouten maken dat er snel een verkeerde beoordeling wordt gemaakt. De waarde van het testen wordt dan nihil omdat je stelselmatig verkeerde aannames maakt…

AB testen wint meer en meer terrein. Het principe van een test waarbij je tegelijkertijd op een random populatie webpagina variant 1 test tegen webpagina variant 2 is veel logischer dan een test waarbij je variant 1 in periode A met variant 2 in periode B vergelijkt. Dit vanwege het simpele feit dat de omgevingsvariabelen in de AB test stabiel zijn en evenveel invloed hebben op de uitkomst. Bij het uitvoeren en analyseren van AB testen kun je echter zoveel fouten maken dat er snel een verkeerde beoordeling wordt gemaakt. De waarde van het testen wordt dan nihil omdat je stelselmatig verkeerde aannames maakt…

Ik schreef hier al eerder over op webanalisten.nl (AB & MV testen: voorkom deze 2 veelgemaakte fouten!). Hier besprak ik de tekortkoming bij het testen tegen 1 conversiepunt en de must om niet te testen tegen de default, maar tegen een kopie van de default pagina. In dit artikel wil ik je waarschuwen over de invloed van uitgestelde conversie op je AB test resultaten.

Koopgedrag

Niet elke bezoeker behaalt het einddoel van zijn bezoek direct bij zijn eerste bezoek. Het afnemen van diensten of producten, daar gaat vaak een aantal dagen overheen en soms nog aanzienlijk langer. Zodra je een AB test start zul je dus bezoekers op 1 van de pagina variaties krijgen die al eerder op jouw website zijn geweest. Bezoekers die al eerder een deel van het conversiepad hebben afgelegd.

Hierboven kun je aflezen dat voor de getoonde cijfers 20% van het bezoek pas vanaf 3 dagen sinds het laatste campagne bezoek een conversie maakt. Dit zal natuurlijk op elke website anders zijn, maar het is een praktijkvoorbeeld dat heel normaal is.

Invloed op de AB test

Wanneer je nu een AB test laat lopen waarbij de verschillende varianten erg van elkaar verschillen, zullen de bezoekers die eerst rondshopten op de default variant (voorafgaand aan de test) toch wel even een paar keer met de ogen knipperen op de nieuwe variant. Het is zeer aannemelijk dat de eerdere bezoekers relatief beter converteren op de default versie ten opzichte van een nieuwevariant in vergelijking met bezoekers die voor het eerst op de pagina komen. Dit zal zeker zo zijn wanneer het vorige bezoek nog vrij recent was (en men de pagina indeling nog goed in het hoofd heeft). De test resultaten kunnen dus een negatief effect tonen in de eerste periode bij een variant die sterk afwijkt van de default variant.

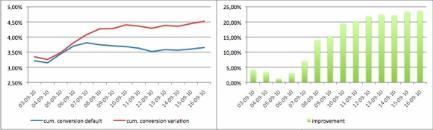

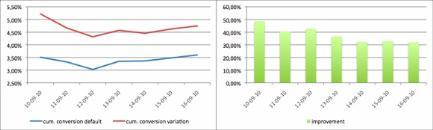

In de variant hierboven zie je de cummulatieve conversie grafieken (elke dag het aantal aankopen over de testperiode tot dan toe) van een default pagina en een variant. De variant converteert duidelijk beter, maar dit verschil wordt pas gemaakt na een aantal dagen. In de eerste paar dagen is het verschil in conversie nagenoeg gelijk. Hier presteert de variatie vanwege een bepaalde reden aantoonbaar lager dan de default versie.

Hoe maak je een betere analyse?

Wat is nu de oplossing voor dit probleem? Je zou zeggen dat je de test alleen moet tonen aan bezoekers die al minimaal een bepaalde aantal dagen (bijvoorbeeld 14) de te testen pagina niet meer hebben gezien. Je vergelijkt dan alleen het gedrag van redelijke nieuwe bezoekers. Het herhaalbezoek hierbinnen kan niet meer echt schrikken van een extreme variant, omdat de tijdsperiode tussen het zien van beide versies erg groot was.

Wat je hier echter vergeet is het feit dat een deel van je bezoekers met uitgestelde conversie eerst op de PC op het werk naar je website heeft gekeken en daarna bijvoorbeeld vanaf huis. Als dit tijdens de test gebeurd (en men switched van versie) is het effect op beide varianten even groot. Wanneer dit echter gebeurd vlak voor en vlak na de start van de test zal dit alsnog het ongewenste effect kunnen hebben.

Hierboven zie je dezelfde test resultaten maar dan alleen over de laatste week (nog steeds in een cummulatieve grafiek). Je ziet dat het daadwerkelijke verschil er direct is. De afwijking in het begin (iets hoger percentage voor de variatie) ontstaat door het gebrek aan significantie (omdat het aantal bezoekers en conversies nog niet groot genoeg is), de stabiliteit volgt later. Je ziet dat het conversieverschil absoluut gezien met de eerste vergelijking wel ongeveer 7% is! (nu 30% en in de eerste grafiek 23%). Bij een hele lange test zal de eerste vergelijking bij een redelijk gelijkblijvende externe invloed natuurlijk ook naar de 30% toegroeien, maar zo lang test je niet…

Nu heeft de uitgestelde conversie in dit voorbeeld geen effect gehad op het bepalen van de winnaar, maar het verschil in absoluut percentage zou in een andere test, waar het verschil in conversie tussen de varianten minder groot is, er zomaar voor kunnen zorgen dat de verkeerde winnaar wordt aangewezen….

Wees op je hoede!

Reacties (4)