Het aantal tools en technieken dat het leven van een online marketeer makkelijker maakt neemt gestaag toe: A/B testen, mulitvariate testing, behavioural targetting, retargetting, engagement mapping, 101 webanalyticspakketten (die helaas nog niet zover zijn als Dennis Mortensen wil).

Maar wat nog achterblijft imho zijn de onderliggende theorieën die het gebruik van deze tools echt rechtvaardigen en waardoor je ook weet waarom iets werkt of niet. Grappig is dat veel van deze theorieën al jaren gebruikt worden door onze off-line collega´s.

Wat mij ook opvalt is dat bij, bijvoorbeeld een A/B test, vaak geen hypothese wordt opgesteld en dat verwachting niet van tevoren gedefinieerd worden.

´Meten is weten´ wordt er vaak gezegd en we meten ook al heel veel. Maar meten is pas het begin. Inzicht, dat is de clue. Weten in welke context de metingen verricht zijn: seizoeninvloeden, vakanties, rentewijzigingen, concurrentie, temperatuur (want bijna niemand kruipt actief achter een computer als het buiten warmer dan 25C is), dagdeel, gedrag, etc. Weten waarom een bepaalde testvariant beter werkt dan een andere en niet alleen dat deze beter werkt.

Ik ben er nog niet uit maar ik wil graag met jullie delen wat we bij de ABN AMRO Hypotheken Groep gedaan en geleerd hebben op basis van het gebruik van diverse theorieën en wat de voordelen zijn van het gefundeerd testen.

Gebruik van kleuren in buttons

Welke kleur werkt het beste in de CTA van een banner? Er zijn miljoenen kleuren, als je zonder na te denken een aantal kleuren gaat testen dan ben je geruime tijd bezig voordat je de best presterende gevonden hebt.

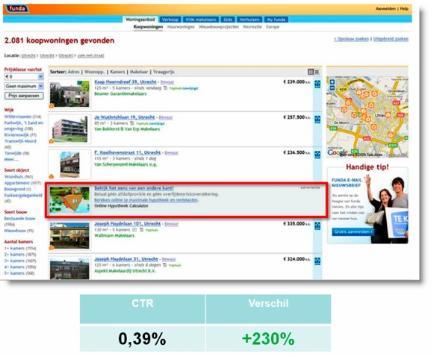

Na wat onderzoek vond ik dit overzicht van Karel Geenen waarin wordt gepostuleerd dat oranje de beste kleur is voor een CTA. Op basis hiervan hebben we de onderstaande test uitgevoerd op de fotopagina van Funda (is alweer een tijdje geleden).

Het testen van verschillende kleuren wordt vaak beperkt doordat vast gehouden moet worden aan de huisstijl kleuren van een website. Hierdoor kun je dus conversies mislopen en dat is voer voor interessante interne discussies 🙂

Zoals ziet, blijkt het namelijk gewoon te werken. Dit is echter niet alles want experimenten van Ton Wesseling van Online Dialogue laten zien dat een rode knop beter werkt tijdens kantooruren en dat een groene knop beter presteert tijdens weekenden [note: Ton Wesseling maakte hier een nuance op in een reactie bij dit artikel]. Binnen de context van de hier beschreven test werkt oranje (overall) het beste maar mogelijk kunnen deze resultaten nog verbeteren wanneer deze gesegmenteerd worden op basis van dagen en misschien zelfs tijdstippen. Over het waarom bestaan veel ideeën maar hier is nog niet met zekerheid iets over te zeggen.

Social Validation

Mensen willen graag bij een groep horen en vertonen daarom veel sociaal geaccepteerd gedrag, groepsgedrag. De gedachte bestaat dat het gedrag van de groep klopt, dat de groep het beter weet: horeca-ondernemers weten dit al langer. Je stapt eerder een vol restaurant in dan een leeg restaurant omdat je denkt dat in een vol restaurant het eten beter is (anders zou deze niet vol zitten). Daarom zetten horeca ondernemers de eerste klanten zoveel mogelijk aan het raam…

Social Proof is hier onderdeel van. Door aan te geven wat de groep doet kun je (bepaalde) mensen over een drempel heen helpen. Een bekend voorbeeld hiervan is bijvoorbeeld de top 10 meest verkochte boeken. Een andere mogelijkheid is om aan te geven hoeveel mensen deze keuze reeds gemaakt hebben.

Evert Stobbe van ABN AMRO heeft dit getest en zoals bovenstaand geimplementeerd en dat leverde aanzienlijk meer conversie op. Ook Independer past dit toe op hun pagina´s. Op de ´oude´ website van MoneYou hebben we dit als volgt getest:

De resultaten waren verrassend. Hoewel de pagina met social proof 5% beter presteerde dan de originele pagina, bleek de 3de variant die we als 0-meting lieten meedraaien het 13% beter te doen. We zullen dus nog verder moeten testen om de juiste manier te vinden om social proof in te zetten. Mogelijk werkt het beter als de social proof tekst boven in niet in de button staat.

Mimicry

Spiegelneuronen zijn neuronen die niet alleen getriggered worden bij het zelf doen van een actie of een handeling maar ook bij het zien van deze actie of handeling bij iemand anders.

Daarom zal een pas geborene ook haar of zijn tong uitsteken terwijl deze amper controle heeft over de motoriek, wanneer jij ook je tong uitsteekt en ga je gapen wanneer je iemand anders ook ziet gapen.

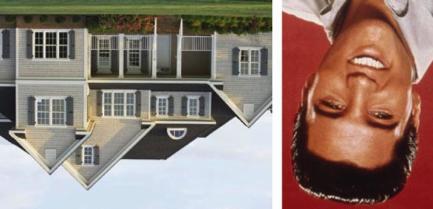

Naar men aanneemt spelen ze o.a. een rol bij het leren van nieuwe vaardigheden door imitatie maar ook bij het kopieren van ´gedrag´. Eyetracking testen hebben het onderstaande opgeleverd:

![]()

Dit hebben we als volgt getest in banners:

Hoewel dit resulteerde in een hoger conversie percentage waren de resultaten niet goed genoeg om dit structureel in te zetten in de huidige banners. Momenteel werken we aan nieuwe banners waarbij we dit opnieuw gaan testen. We zetten dit al wel in op specifieke landingspagina´s:

Onderscheid boven en onder

Het herkennen van mensen is een proces waarbij je niet hoeft na te denken, het is direct. Dit is echter niet het geval wanneer je een foto omdraait (face inversion effect). Gevoelsmatig is dit logisch maar wetenschappelijk niet. Daarbij komt dat het gemakkelijker is om dingen en voorwerpen omgekeerd te herkennen dan mensen.

Het scannen van woningen, bijvoorbeeld in een lijst van resultaten gebeurd relatief automatisch. Wanneer we een omgekeerde foto aan deze lijst toevoegen, wordt hierdoor het automatisch proces doorbroken waardoor bezoekers weer gaan lezen.

Er zijn meerdere manieren om dit effect te bewerkstellingen maar deze oplossing is subtieler dan ´danger, food or sex´ en resulteerde in een significante verhoging van de CTR (+230%).

Veel van de hier besproken theorieën zijn al langer bekend bij offline marketeers en vinden nu ook gestaag hun weg bij online marketeer.

Gestructureerd testen

Een gedegen fundering van je online ideeën en uitingen heeft diverse voordelen:

- Je kunt beter met iemand communiceren indien je weet hoe deze persoon zou kunnen reageren.

- Het beperken van het aantal mogelijke (test) variaties waarmee je de kans op succes vergroot.

- Je kunt beter aansluiten op de behoeften van een bezoeker.

- Je kunt resultaten ook reproduceren binnen een andere omgeving / andere context.

Ter herinnering nog een aantal extra redenen om te testen van Ronny Kohavi : “Data Trumps Intuition”.

- Bij Amazon resulteert de helft van de testen niet tot een verbetering.

- 75% van de belangrijke business beslissingen en verbeterings-ideeën hebben geen invloed of schaden de performance van een website.

- Onze intuitie is een slechte raadgever: 2/3 van de ideeen leiden niet tot de verwachte verbeteringen.

- Bij Microsoft resulteerde 1/3 van de ideeën die getest werden in een verbetering van de resultaten. 1/3 resulteerde in slechtere resultaten en nog eens 1/3 resulteerde in gelijkblijvende resultaten.

Tijdens het testen van verschillende variaties vind ik het persoonlijk altijd zeer frustrerend dat ik regelmatig verkeerd inschat welke variatie uiteindelijk de beste resultaten oplevert (daarom moet je ook altijd alles testen en testen en testen) maar nog erger vind ik het als ik niet kan achterhalen waarom iets werkt of niet. Het gebruik van theorieën en hypotheses heeft deze pijn een stukje verzacht 🙂

Reacties (16)